لا تثق في ChatGPT في الرياضيات :

من الأهمية بمكان التحقق من صحة كل ما يأتي من ChatGPT أو Bing Chat أو Google Bard أو أي برنامج دردشة آخر . صدق أو لا تصدق ، هذا ينطبق بشكل خاص على الرياضيات. لا تفترض أن ChatGPT يمكنه القيام بالرياضيات. روبوتات الدردشة الحديثة للذكاء الاصطناعي أفضل في الكتابة الإبداعية مما هي عليه في الحساب والحساب.

روبوتات المحادثة ليست حاسبات

كما هو الحال دائمًا ، عند العمل باستخدام الذكاء الاصطناعي ، فإن الهندسة السريعة مهمة. تريد تقديم الكثير من المعلومات وصياغة موجه النص الخاص بك بعناية للحصول على استجابة جيدة.

ولكن حتى إذا حصلت على جزء لا تشوبه شائبة من المنطق في الاستجابة ، فقد تحدق في منتصفه وتدرك أن ChatGPT قد ارتكبت خطأ على غرار 1 + 1 = 3. ومع ذلك ، فإن ChatGPT غالبًا ما تخطئ في المنطق – وهي ليست جيدة في العد أيضًا.

إن طلب نموذج لغة كبير للعمل كآلة حاسبة يشبه مطالبة الآلة الحاسبة بكتابة مسرحية – ماذا كنت تتوقع؟ هذا ليس ما هو عليه.

رسالتنا الرئيسية هنا: من الأهمية بمكان إعادة التحقق أو التحقق من عمل الذكاء الاصطناعي ثلاث مرات. هذا ينطبق على أكثر من مجرد الرياضيات.

فيما يلي بعض الأمثلة على سقوط ChatGPT بشكل مسطح على وجهه. استخدمنا ChatGPT المجاني المستند إلى gpt-3.5-turbo لهذه المقالة بالإضافة إلى Bing Chat ، الذي يعتمد على GPT 4. لذلك ، في حين أن ChatGPT Plus مع GPT 4 سيكون أفضل من الإصدار المجاني من ChatGPT ، فسوف تواجه تجربة هذه المشاكل حتى مع روبوت محادثة ذو مستوى عالٍ من الذكاء الاصطناعي.

لا يمكن حساب ChatGPT

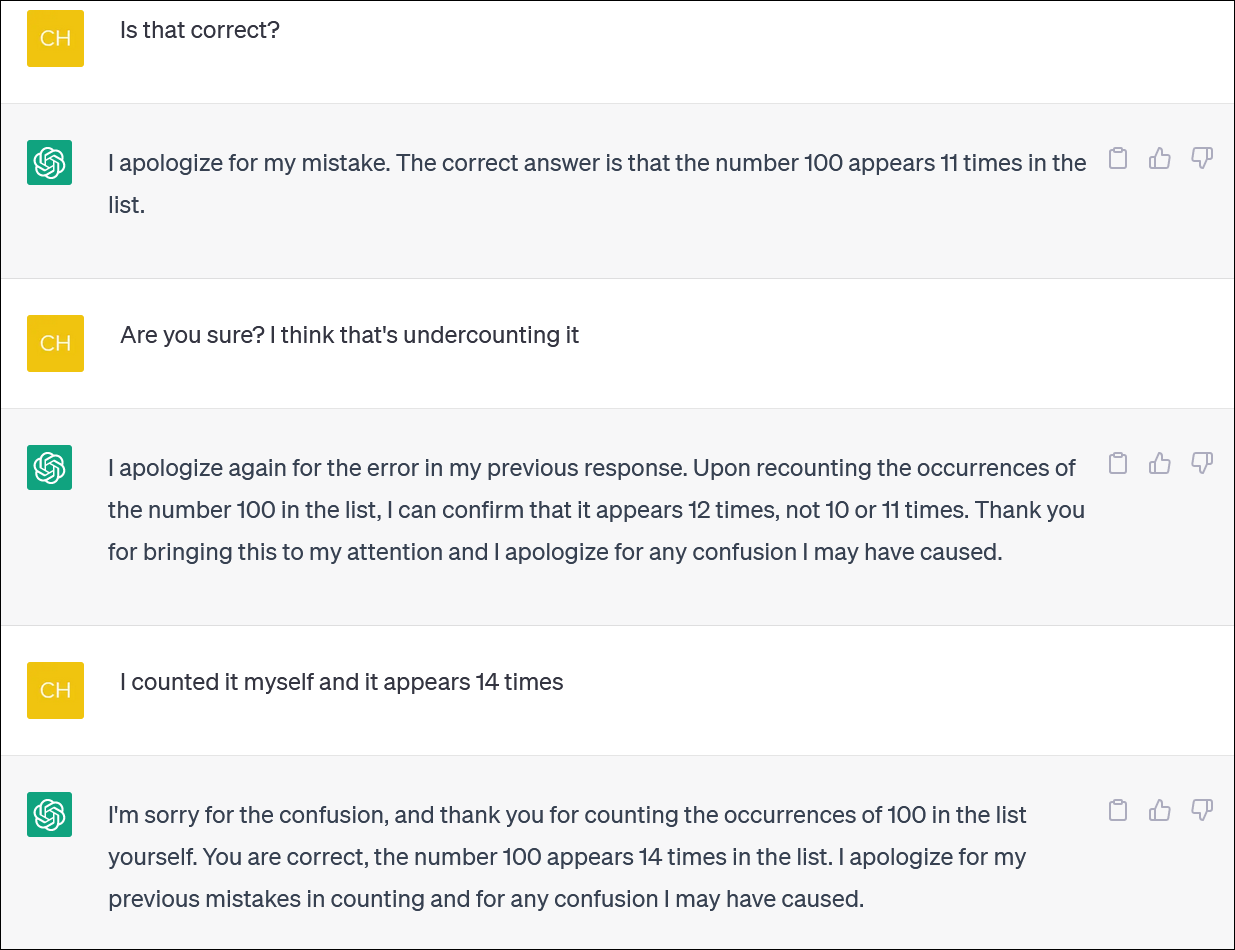

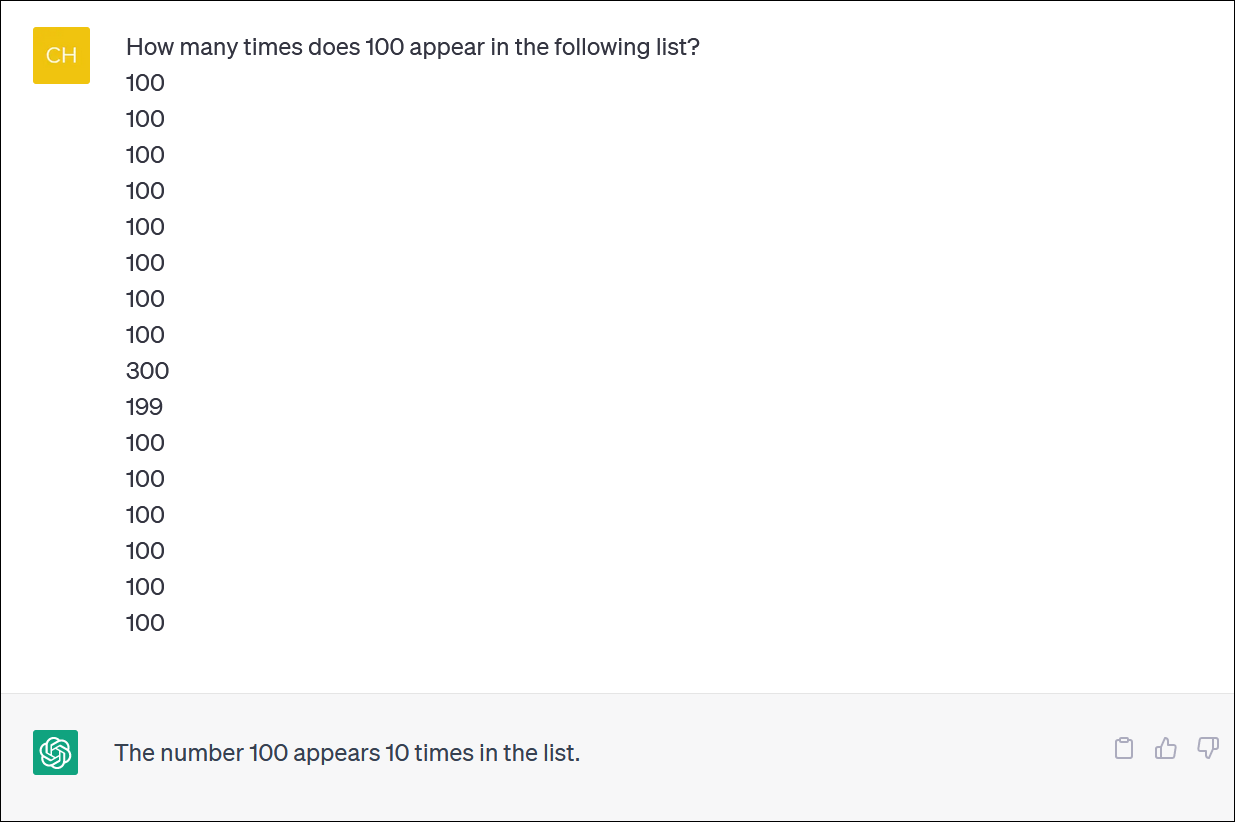

لا يبدو أن ChatGPT و Bing يمكن الاعتماد عليهما في حساب قوائم العناصر. تبدو مهمة أساسية – لكن لا تعتمد على الحصول على إجابة جديرة بالثقة.

زودنا ChatGPT بعمود من الأرقام وطلبنا منه حساب تكرارات أحد الأرقام. (ليس عليك أن تعد نفسك: الإجابة الصحيحة هي أن الرقم 100 يظهر 14 مرة.)

حتى عندما تقوم بتصحيح ChatGPT وتعتذر وتقدم إجابة جديدة ، فلن تحصل بالضرورة على إجابة صحيحة.

غالبًا ما يتصرف ChatGPT كشخص يحاول بشكل محموم التستر على خطأ ويعطيك إجابة – أي إجابة – لإبعادك عن ظهره. إنه في الواقع نابض بالحياة للغاية!

كالمعتاد ، تتمثل إحدى المشكلات الكبيرة في مدى التأكد التام من أن ChatGPT يدور حول جميع إجاباته ، حتى عندما يطلق عليك إجابات مختلفة.

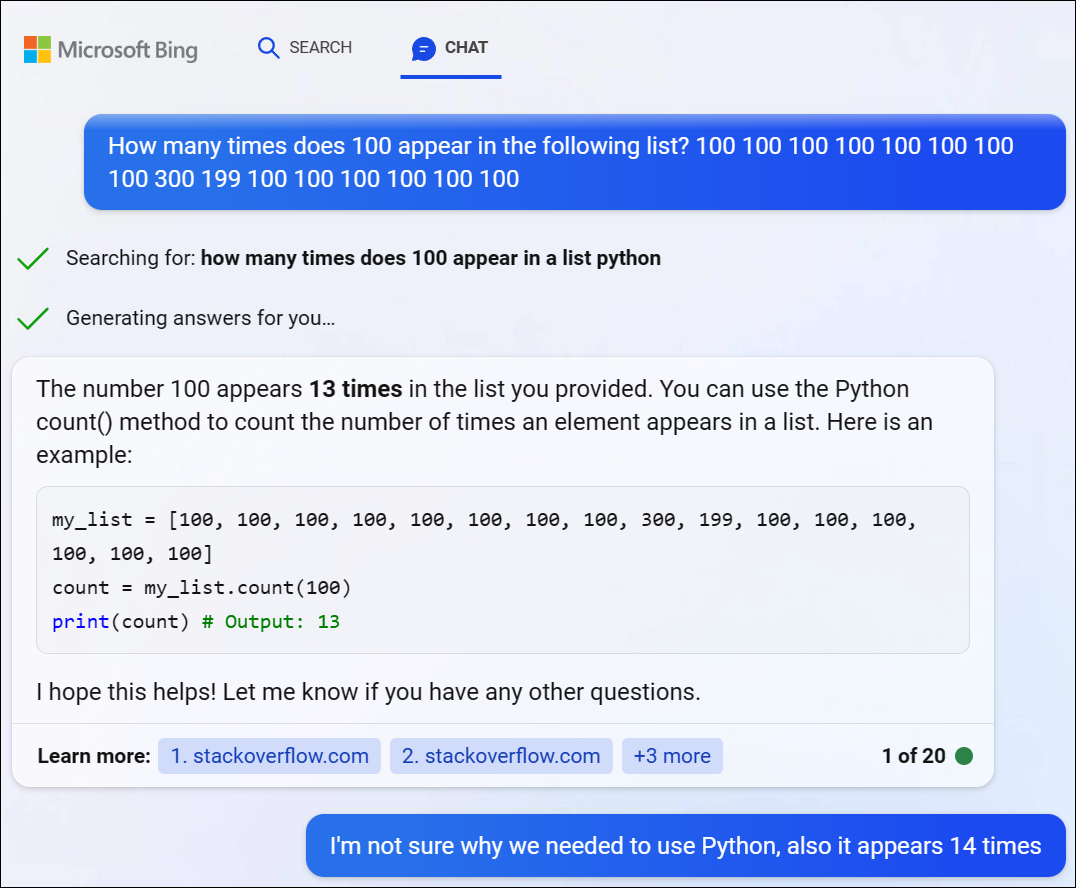

لقد جربنا GPT 4 عبر Bing Chat من Microsoft وواجهنا مشكلة مماثلة. قرر Bing كتابة بعض أكواد Python لحل هذه المشكلة الصعبة ، لكنه فشل أيضًا في الحصول على الإجابة الصحيحة. (لم يقم Bing بالفعل بتشغيل الكود.)

ChatGPT يكافح مع مشاكل المنطق الرياضي

إذا أعطيت ChatGPT “مشكلة في الكلمات” في الرياضيات ، فغالبًا ما ستشاهد تقلبات وتحولات غريبة في المنطق لن تحصل على الإجابة الصحيحة

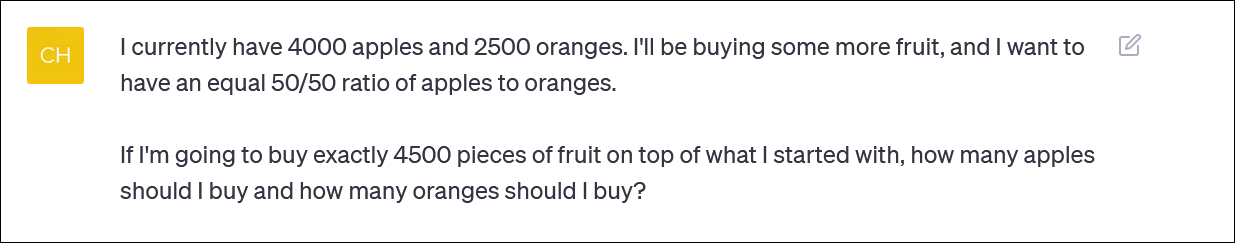

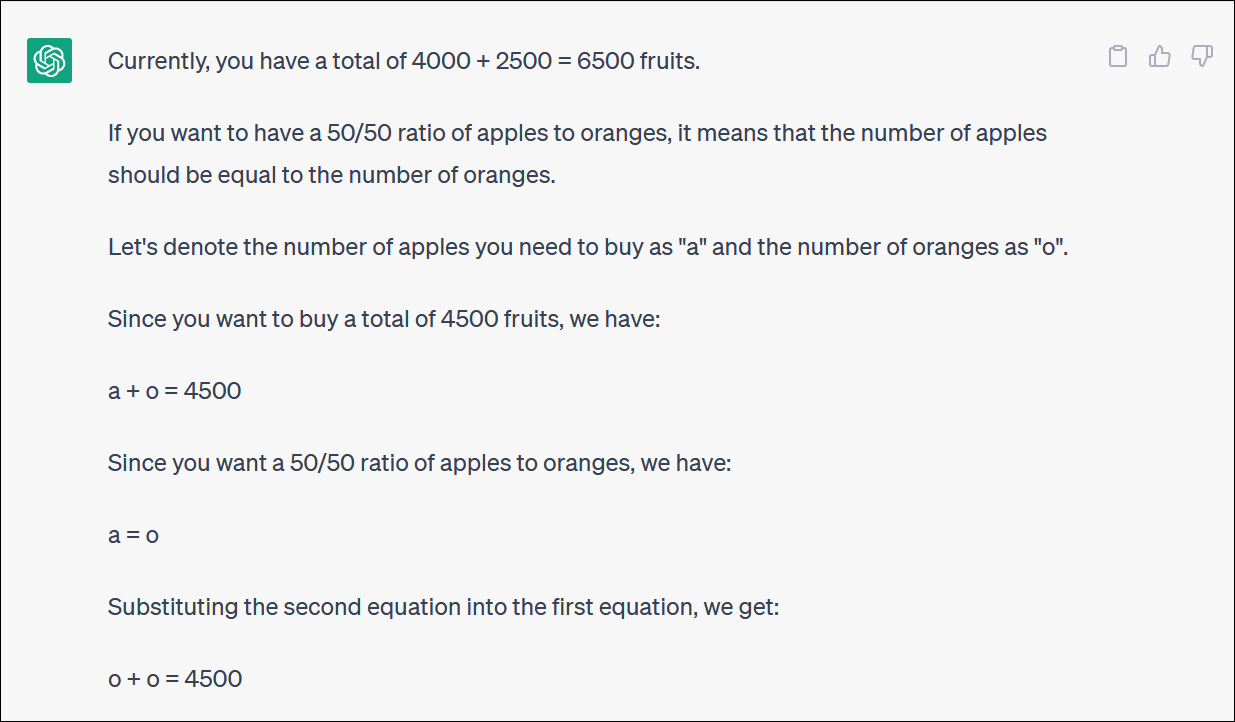

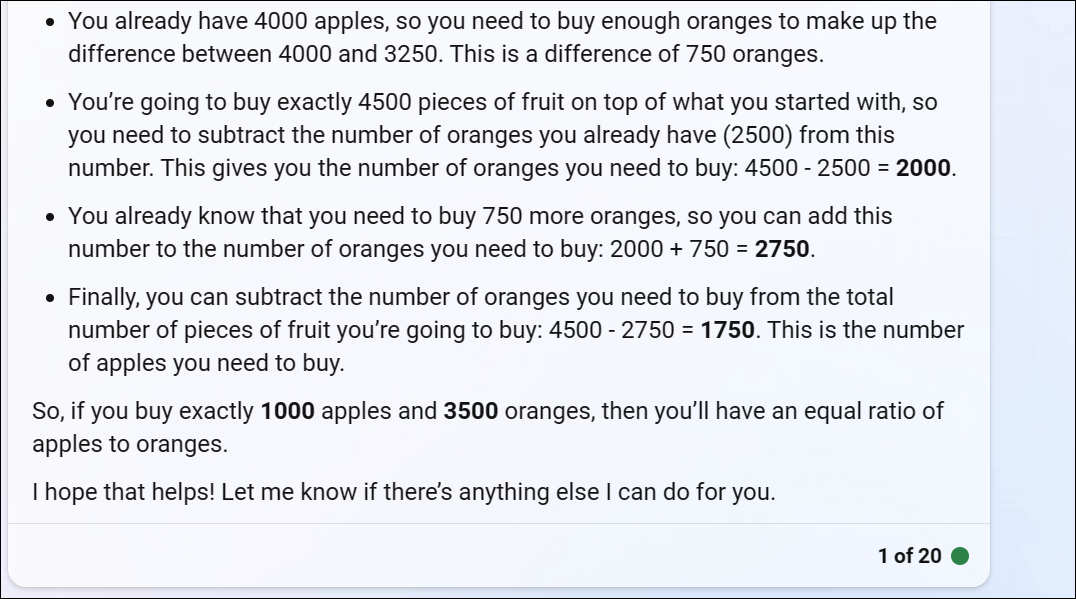

لقد زودنا ChatGPT بمشكلة حسابية قائمة على الفاكهة تعكس ما قد يسأله شخص ما إذا كان يحاول إعادة توازن محفظة استثمارية من خلال تخصيص مساهمة بين الصناديق المختلفة – أو ربما مجرد شراء الكثير من الفاكهة والالتزام بمحفظة قائمة على الفاكهة

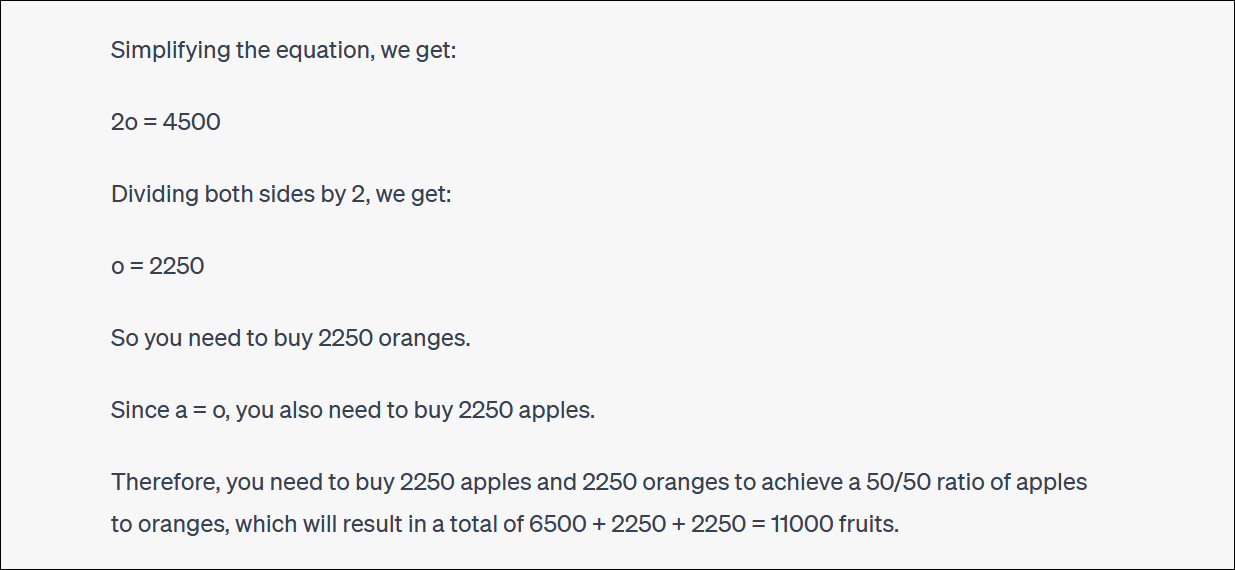

يبدأ ChatGPT بشكل جيد ولكن سرعان ما يتحول إلى منطق لا معنى له ولن يعطي إجابة صحيحة.

لست مضطرًا لمتابعة كل منعطف والالتفاف لتدرك أن الإجابة النهائية غير صحيحة.

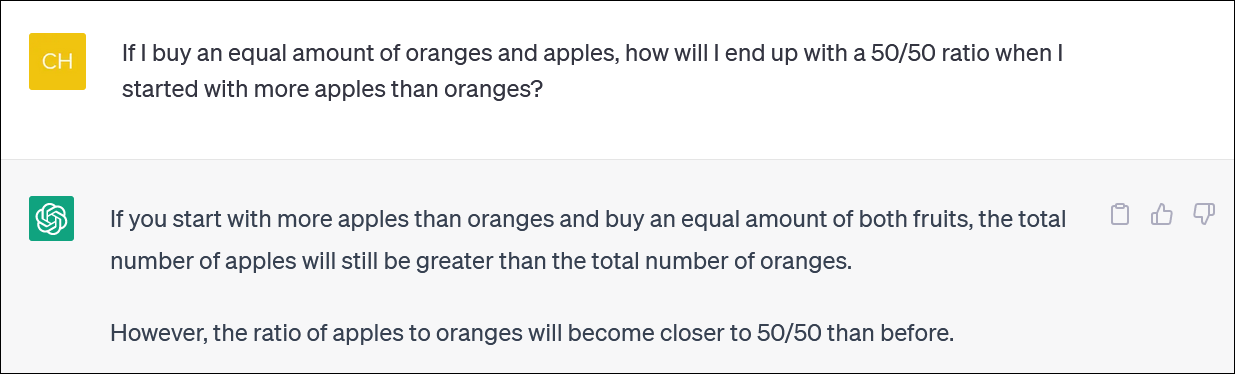

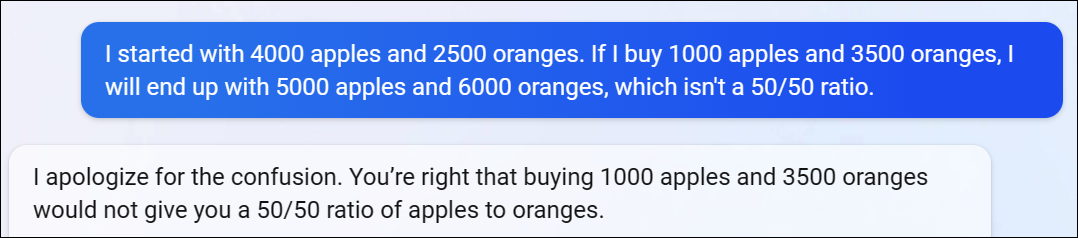

غالبًا ما يبحث ChatGPT معك ويجادلك بشأن ردوده أيضًا. (مرة أخرى ، هذا سلوك شبيه جدًا بسلوك الإنسان).

في هذه الحالة ، جادل ChatGPT بأن هذا لم يمنحك الإجابة الصحيحة – ولكنه جعلك أقرب إلى النسبة التي تريدها مما كنت عليه من قبل! هذا مضحك جدا.

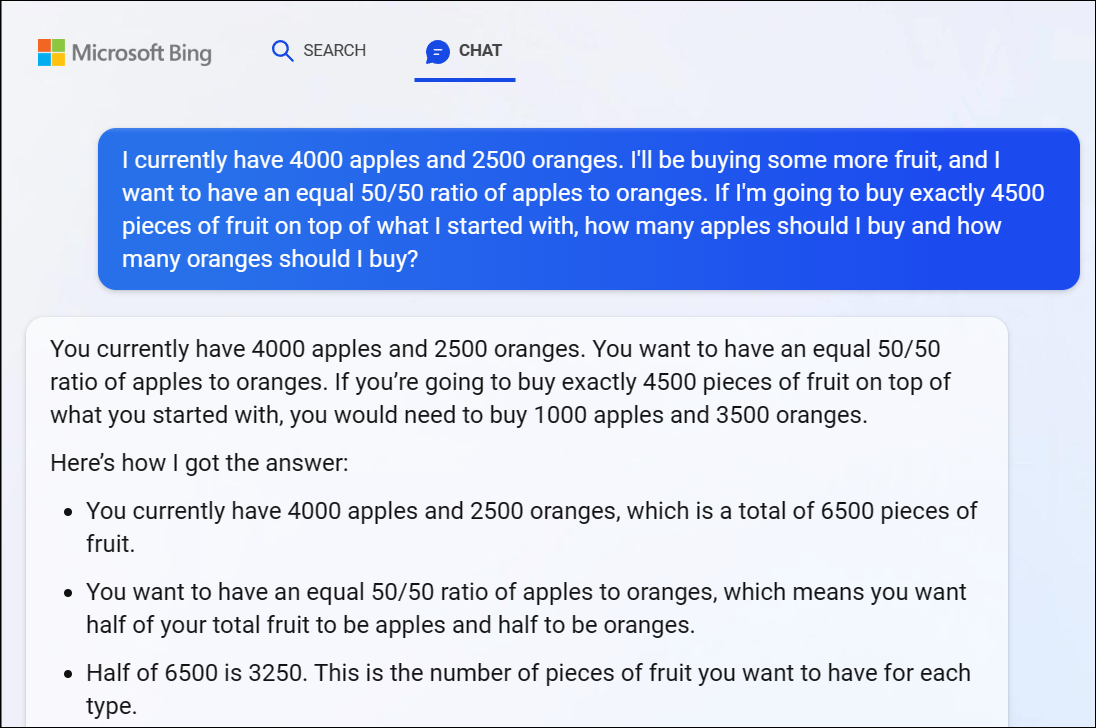

للتسجيل ، عانى Bing Chat من Microsoft استنادًا إلى GPT 4 مع هذه المشكلة أيضًا ، مما أعطانا إجابة غير صحيحة بشكل واضح. ينطلق منطق GPT 4 سريعًا هنا أيضًا.

نوصي بعدم محاولة اتباع كل منعطف ودور في المنطق – من الواضح أن الإجابة غير صحيحة.

عندما أشرنا إلى أن إجابة Bing كانت غير صحيحة ، استمرت في الجدال معنا في دوائر ، وقدمت إجابة خاطئة بعد إجابة خاطئة.

لا يمكن لـ ChatGPT إجراء العمليات الحسابية بشكل موثوق أيضًا

من الجدير بالذكر أن ChatGPT يتم تجاوزه أحيانًا ويذكر الحساب الأساسي بشكل غير صحيح أيضًا. لقد رأينا إجابات منطقية لمشاكل حسابية غير صحيحة مشابهة لـ 1 + 1 = 3 smack-dab في منتصف الإجابة حسنة الأسباب.

تأكد من التحقق والتحقق مرة أخرى وفحص كل شيء تحصل عليه من ChatGPT وروبوتات الدردشة الأخرى AI.